Principal

Desbloqueando la IA empresarial con innovación open source: cualquier modelo, acelerador o nube

Por: Chris Wright, director de tecnología y vicepresidente sénior, Ingeniero Global, Red Hat

“Cualquier carga de trabajo, cualquier aplicación, en cualquier lugar” fue el mantra del Red Hat Summit 2023. Es cierto que, en los últimos dos años, hemos visto algunos cambios en TI. Pero la visión de Red Hat no ha cambiado, ha evolucionado.

“Cualquier modelo, acelerador o nube”.

Ese es el mensaje de la nube híbrida para la era de la IA. Y la mejor parte es que, al igual que la “antigua” nube híbrida, la innovación open source es la que impulsa todo. En el Red Hat Summit mostramos cómo los ecosistemas de IA estructurados en torno al open source y a modelos abiertos pueden generar nuevas opciones para las empresas.

La apertura trae consigo la posibilidad de elegir y esta libertad da paso a una mayor flexibilidad: desde el modelo que mejor responde a las necesidades de la empresa hasta el acelerador subyacente y el lugar donde se ejecutará efectivamente la carga de trabajo. Las estrategias de IA exitosas seguirán a los datos, dondequiera que se encuentren en la nube híbrida.

¿Y qué impulsa a la nube híbrida? El open source.

La inferencia potencia la IA

En mi opinión, debemos empezar a mirar más allá de los modelos. Sí, es verdad que los modelos son muy importantes para las estrategias de IA. Pero sin la inferencia, la faceta «práctica» de la IA, los modelos son simplemente conjuntos de datos que no «hacen» nada. La inferencia se refiere a la rapidez con la que un modelo responde a la información ingresada por el usuario y a la eficiencia con la que se pueden tomar decisiones en recursos informáticos acelerados. En última instancia, las respuestas lentas y la poca eficiencia cuestan dinero y generan desconfianza en el cliente.

Es por eso que me entusiasma mucho que Red Hat priorice la inferencia en nuestro trabajo con la IA open source, comenzando con el lanzamiento de Red Hat AI Inference Server. Esta solución, que surge a partir del proyecto open source vLLM líder y está optimizada con tecnologías Neural Magic, ofrece a las implementaciones de IA un servidor de inferencia con soporte, ciclo de vida completo y listo para producción. Lo mejor de todo es que puede rastrear tus datos dondequiera que se encuentren, ya que la solución funcionará con cualquier plataforma de Linux, cualquier distribución de Kubernetes, Red Hat o de cualquier otro modo.

¿Qué es mejor que la IA empresarial? La IA empresarial a gran escala

La aplicación estrella de la TI empresarial no es una única carga de trabajo unificada ni un nuevo servicio en la nube: es la capacidad de escalar de forma rápida y eficiente. Esto también se aplica a la IA. Sin embargo, la IA presenta una particularidad: los recursos informáticos acelerados que sustentan las cargas de trabajo de IA también deben escalarse. Esta no es una tarea fácil, en vista de los gastos y las habilidades necesarias para implementar este hardware en la forma debida.

Lo que necesitamos no es solo la capacidad de escalar la IA, sino también de distribuir cargas de trabajo masivas de IA entre múltiples clústeres de computación acelerada. Esto se ve agravado por el escalado del tiempo de inferencia que requieren los modelos de razonamiento y la IA agéntica. Al compartir la carga, se pueden reducir los problemas de rendimiento, mejorar la eficiencia y, en última instancia, la experiencia del usuario. Con el proyecto llm-d de código abierto, Red Hat ha tomado medidas para hacer frente a este problema.

El proyecto llm-d, dirigido por Red Hat y respaldado por líderes del sector de la IA en aceleración de hardware, desarrollo de modelos y cloud computing, combina el poder comprobado de la orquestación de Kubernetes con vLLM, uniendo dos referentes del open source para responder a una necesidad muy real. Junto con tecnologías como el enrutamiento de redes con IA y la descarga de caché KV, entre otras, llm-d descentraliza y democratiza la inferencia de IA y, de ese modo, ayuda a las empresas a optimizar sus recursos informáticos y disponer de cargas de trabajo de IA más efectivas y de menor costo.

Abierto a lo que se viene en IA, no solo al código

Llm-d y vLLM, incluidos en Red Hat AI Inference Server, son tecnologías open source preparadas para responder a los desafíos de la IA empresarial de hoy. Sin embargo, las comunidades de desarrollo no se limitan a analizar lo que se necesita hacer ahora. Las tecnologías de IA tienen una forma particular de acortar los plazos: el vértigo de la innovación implica que algo que se creía que no plantearía un desafío en años, de repente debe afrontarse de lleno.

Por ese motivo es que Red Hat está destinando recursos a la fase de desarrollo inicial de Llama Stack, el proyecto liderado por Meta que ofrece componentes básicos y API estandarizados para los ciclos de vida de las aplicaciones de IA generativa. Además, Llama Stack es ideal para crear aplicaciones de IA agénticas, que representan una nueva evolución de las potentes cargas de trabajo de IA generativa que vemos hoy en día. Más allá de su desarrollo inicial, Llama Stack está disponible como versión preliminar para desarrolladores dentro de Red Hat AI, para aquellas empresas que hoy quieran comprometerse con el futuro.

En lo que respecta a los agentes de IA, aún no contamos con un protocolo común para el modo en que otras aplicaciones les proporcionan contexto e información. Aquí es donde entra en juego el protocolo de contexto de modelo (MCP). Desarrollado y convertido en open source por Anthropic a fines de 2024, se trata de un protocolo estandarizado para las interacciones entre agente y aplicación, similar a los protocolos cliente-servidor de la informática tradicional. Pero lo más importante es que las actuales aplicaciones pueden, de improviso, valerse de la IA sin necesidad de una reimplementación a gran escala. Esto es importantísimo y no sería posible si no fuera por el poder del open source. Al igual que Llama Stack, MCP está disponible como versión preliminar para desarrolladores en la plataforma de Red Hat AI.

Los modelos propietarios de IA pueden haber logrado una ventaja inicial, pero no hay duda de que los ecosistemas abiertos los han superado, en especial en cuanto al software que sustenta estos modelos de IA de próxima generación. Gracias a vLLM y llm-d, junto con productos empresariales open source con seguridad reforzada, el futuro de la IA es prometedor, independientemente del modelo, el acelerador o la nube, y está impulsado por el open source y por Red Hat.

Opinet

La depresión como encrucijada existencial- Lisandro Prieto Femenía

“La lucha misma hacia las cumbres basta para llenar un corazón. Hay que imaginarse a Sísifo feliz”

Camus, 1955/1942, p. 78.

Hoy quiero invitarlos a reflexionar sobre la depresión, un fenómeno que no se agota en un diagnóstico clínico ni se limita a la simple suma de neurotransmisores. De hecho, se alza como un problema filosófico que fuerza a repensar la relación intrínseca entre sentido, libertad e identidad. Cuando la vida parece vaciarse de contenido, es decir, cuando el mundo circundante muestra su silencio ante nuestras demandas de coherencia, surge la pregunta por el sentido que ha atravesado toda la reflexión existencialista.

El pensador Albert Camus interrogó frontalmente la condición humana frente al absurdo, señalando que la conciencia de ese choque brutal entre nuestra sed innata de significado y la indiferencia cósmica no debe conducir, sin más, a la rendición. Desde su perspectiva en “El mito de Sísifo”, el absurdo es la consecuencia de un encuentro: “el absurdo nace de esta confrontación entre la llamada humana y el silencio irracional del mundo” (Camus, 1955/1942, p. 30). Si optamos por entender la depresión como una respuesta radical a la experiencia de lo absurdo, encontramos en ella, paradójicamente, una lucidez cargada de dolor, que es el reconocimiento íntimo que los marcos habituales de sentido han colapsado.

Aquella dolorosa lucidez abre, sin embargo, caminos interpretativos notoriamente divergentes. Desde la perspectiva sarteana, la libertad humana se entiende como absoluta y radical, y la consecuente angustia no es otra cosa que la revelación de la nada que subyace a toda elección. Por consiguiente, la depresión podría interpretarse como una forma externa de esa angustia, manifestándose cuando la posibilidad de acción se torna insoportable y la libertad misma se experimenta como una carga sin horizonte. Jean-Paul Sartre sostuvo categóricamente que “el hombre está condenado a ser libre” (Sartre, 2018/1943, p. 627), y que la depresión expone el coste concreto de esta condena: la parálisis de la decisión y la imposibilidad de proyectarse hacia futuros que antes insuflaban motivo a la acción.

Frente a este abismo, Camus propuso una reacción que eludía los consuelos metafísicos y apelaba, en cambio, a la revuelta: afirmar la propia conciencia del absurdo sin por ello renunciar a la vida. De este modo, la tensión entre reconocer la falta de sentido y aún así elegir la permanencia en el mundo constituye uno de los dilemas más punzantes que la depresión impone a la filosofía.

Por su parte, Søren Kierkegaard nos brinda un aporte a esta discusión, sobre todo en los matices cruciales sobre la autenticidad y la desesperanza. Para el danés, la desesperación no es una simple patología, sino una modalidad intrínseca de la relación del yo consigo mismo, a la que definió como “la enfermedad mortal” (Kierkegaard, 2019/1849, p. 12). En su descripción de “La enfermedad mortal”, la desesperación nace de la incapacidad del sujeto de sintetizar las dimensiones constitutivas del yo -lo finito y lo infinito, lo temporal y lo eterno-. Por lo tanto, conlleva una lectura moral y existencial profunda, revelando incoherencias en el modo en que se vive. Vista así, la depresión podría leerse no sólo como un fallo biológico, sino también como una advertencia radical sobre la falta de autenticidad, un llamado perentorio a revisar las propias premisas vitales. No obstante, reducir la desesperación a una mera oportunidad de autenticidad es correr el riesgo de culpabilizar al sujeto que la padece, puesto que la vivencia de vacío es simultáneamente diagnóstico existencial y sufrimiento que desborda cualquier exigencia de realización. Dicha reducción es tan patética e inútil como cuando a un depresivo alguien le dice: “no estés triste” o “échale ganas”.

Este doble filo nos conduce inevitablemente al interrogante sobre el sufrimiento como vía de conocimiento. Existen tradiciones filosóficas que han considerado el padecimiento como una escuela donde se revelan rasgos fundamentales de la condición humana. El abatimiento extremo puede, en ocasiones, destapar verdades incómodas sobre la fragilidad del proyecto, la contingencia de los deseos y la finitud ineludible que subyace a toda esperanza. Empero, afirmar que el sufrimiento depresivo confiere una verdad profunda exige suma cautela. En este punto, es crucial entender que no todo dolor es una epifanía, ya que la agonía puede deformar la percepción, introducir sesgos cognitivos incapacitantes y cerrar todo horizonte de sentido. Por consiguiente, la pregunta filosófica pertinente no es si el sufrimiento ilumina siempre, sino cómo podemos dialogar con él sin caer en la tentación de romantizarlo o de instrumentalizarlo como un acceso privilegiado a la sabiduría.

También la cuestión de la libertad frente a la depresión demanda una respuesta compleja que reconozca las causas biológicas sin neutralizar, por ello, la responsabilidad existencial. Las evidencias científicas sobre predisposiciones genéticas o desequilibrios neuroquímicos no anulan que la experiencia del yo deprimido siga siendo, en su esencia, una situación moral y existencial.

Si bien es cierto que la libertad, entendida como posibilidad de respuesta, se ve gravemente debilitada por condiciones que limitan la capacidad de acción, esta libertad persiste en la medida en que el sujeto logra, con el apoyo adecuado, reconectar con proyecciones significativas.

Existe, además, una lectura crítica que vincula la depresión con formas de resistencia pasiva en el marco social. En sociedades que demandan productividad constante, el colapso anímico puede funcionar como un silencio revelador frente a las exigencias claramente deshumanizadoras. Al respecto, Byung-Chul Han señaló en su obra “La sociedad del cansancio”, cómo la lógica neoliberal produce sujetos agotados, híper-expuestos y auto-explotados. Desde esta óptica, la depresión puede interpretarse como un síntoma social y político más que como un fallo individual, si bien esta interpretación no debe jamás sustituir la atención clínica necesaria con los profesionales pertinentes.

A esta crítica social, se suma la desazón intrínseca a la experiencia de la posmodernidad líquida. El sociólogo ZygmuntBauman, al reflexionar sobre esta nueva configuración, identificó la paradoja de una vida definida por la ausencia de anclajes sólidos: proyectos, vínculos e incluso identidades se vuelven provisorios, flexibles hasta el punto de la fragilidad. En este mundo de opciones ilimitadas, la elección constante se convierte en una condena, pues, como argumenta el autor polaco, “ser moderno significa estar condenado a una elección incesante, a cambiar constantemente, a revisar sin cesar las decisiones tomadas y a estar siempre dispuesto a descartarlas y a tomar otras en su lugar” (Bauman, 2013, p. 88).

Esta saturación de posibilidades conduce a la fatiga de la voluntad donde la satisfacción siempre es fugaz. Por su parte, Gilles Lipovetsky profundizó en esta saturación al describir la era del vacío, donde la hipertrofia del individualismo y el hedonismo conducen a una profunda insatisfacción existencial. El sujeto posmoderno, aunque inmerso en la abundancia material, se siente desarraigado, puesto que “absorto en su culto al bienestar y en la obsesión por sí mismo, se encuentra más sólo y desorientado que nunca” (Lipovetsky, 2008, p. 110). Por lo tanto, el vacío depresivo no es sólo la pérdida de un sentido personal, sino el eco amplificado de una cultura que promete la felicidad a través del consumo y la auto-realización perpetua, pero sólo entrega desazón.

También, el yo en la depresión se fragmenta. La autopercepción moderna se resquebraja y se hacen patentes capas de identidad que la rutina social mantenía ocultas. La drástica disminución de interés, la sensación de extranjería hacia uno mismo y la pérdida de un proyecto vital con sentido son elementos que modifican la conciencia de sí y pueden, paradójicamente, permitir un tipo peculiar de autoconocimiento. Al respeto, Martin Heidegger, en su obra “Ser y tiempo”, habló del “Dasein” (el “ser-ahí”, o sea, nosotros, como seres-en-el-tiempo) como una proyección fundamental hacia el futuro, sosteniendo que perder esa proyección afecta la apertura misma al mundo (Heidegger, 2003/1927). Cuando el proyecto futuro se desvanece, la temporalidad ser contrae y la existencia se centra en un presente paralizante e incapacitante. Desde otro ángulo, la máscara del yo social se ve desenmascarada, de tal forma que lo que emerge en el “yo depresivo” podría ser la revelación de la artimaña de identidades construidas exclusivamente para cumplir roles externos, dejando al descubierto un núcleo doliente que demanda reconocimiento y cuidado.

Paralelamente, la dimensión ética y social impone responsabilidades claras a la colectividad. juzgar moralmente a quien yace en la desesperanza resulta éticamente injusto, por lo que la valoración moral debe distinguir con precisión entre la exigencia de responsabilizar al sujeto y la compasión necesaria que reconoce limitaciones profundas. además, la depresión reclama una respuesta de justicia social ineludible. Si la estructura social vigente produce condiciones que favorecen el sufrimiento psíquico, la ética colectiva debería demandar transformaciones estructurales. En este sentido, Michel Foucault mostró en su “Historia de la locura en la época clásica” cómo las prácticas sociales y los saberes institucionales configuran las posibilidades de subjetivación: así, la patología mental no es únicamente una cuestión médica, sino también política (Foucault, 2012/1961). El deber ante el sufrimiento del otro, en consecuencia, no consiste sólo en consolar, sino en transformar: reclamar por instituciones, redes de apoyo y modos de vida que mitiguen las causas estructurales del padecimiento.

Otro vínculo que no podemos dejar pasar en esta reflexión es la conexión entre depresión y nihilismo. Si el nihilismo es la vivencia del derrumbe de los valores trascendentes, la depresión puede ser una encarnación palpable de esa vivencia. Sin embargo, Friedrich Nietzsche propuso una respuesta activista: la transvaloración, la creatividad que convierte el sufrimiento en una fuerza propulsora. Su llamado, lejos de trivializar el dolor, invita a imaginar posibilidades de sí que logren transformar ese dolor en un motor vital. Por eso, el arte y la filosofía ofrecen rutas de redención parcial, no como remedios mágicos, tampoco como sustitutos de los tratamientos médicos, sino como prácticas capaces de re-encuadrar la experiencia, alimentar la imaginación y abrir horizontes de sentido nuevos. Ciertamente, no todo en la depresión puede sublimarse, pero la creación simbólica persiste como una de las estrategias más poderosas que permiten resistir la noche del ánimo.

En conclusión, queridos lectores, hemos querido demostrar que la depresión convoca a una filosofía que no se conforma con clasificaciones meramente técnicas sino que exija una reflexión profunda que articule el sentido, la libertad, la identidad, la ética y el lenguaje en su intrincada complejidad. Ante la tiranía del rendimiento y la crisis de sentido de nuestro tiempo, ¿estamos dispuestos realmente a repensar las formas sociales que producen este sufrimiento anímico y a crear prácticas de escucha que restituyan un nombre y una compañía a quienes se ven obligados a callar?

Más allá de la clínica, que es fundamental, ¿cómo podemos sostener la tensión irresoluble entre reconocer las causas biológicas innegables y, al mismo tiempo, asumir las responsabilidades éticas y políticas sin caer en la culpa individualizadora ni en la despolitización facilitas del dolor ajeno? Y, por último, ante el silencio opresivo que la depresión impone en la vida de un ser humano, ¿qué modos de palabra, qué gestos artísticos y qué acciones colectivas pueden, de verdad, abrir una rendija hacia nuevos y urgentes porvenires existenciales? Que estas preguntas resuenen y persistan es la condición mínima para no dejar a la deriva a quienes atraviesan, en la más absoluta soledad, la noche profunda del alma.

Referencias

Bauman, Z. (2013). Modernidad líquida. Fondo de Cultura Económica.

Camus, A. (1955). El mito de Sísifo (J. O’Brien, Trad.). Gallimard/Hamish Hamilton. (Obra original publicada en 1942).

Foucault, M. (2012). Historia de la locura en la época clásica. Siglo XXI. (Obra original publicada en 1961).

Han, B.-C. (2012). La sociedad del cansancio. Herder.

Heidegger, M. (2003). Ser y tiempo. Trotta. (Obra original publicada en 1927).

Kierkegaard, S. (2019). La enfermedad mortal. Alianza Editorial. (Obra original publicada en 1849).

Lipovetsky, G. (2008). La era del vacío: Ensayos sobre el individualismo contemporáneo. Anagrama.

Sartre, J.-P. (2018). El ser y la nada: Ensayo de ontología fenomenológica. Losada. (Obra original publicada en 1943).

Wittgenstein, L. (2009). Tractatuslogico-philosophicus. Routledge. (Obra original publicada en 1921)

Jetset

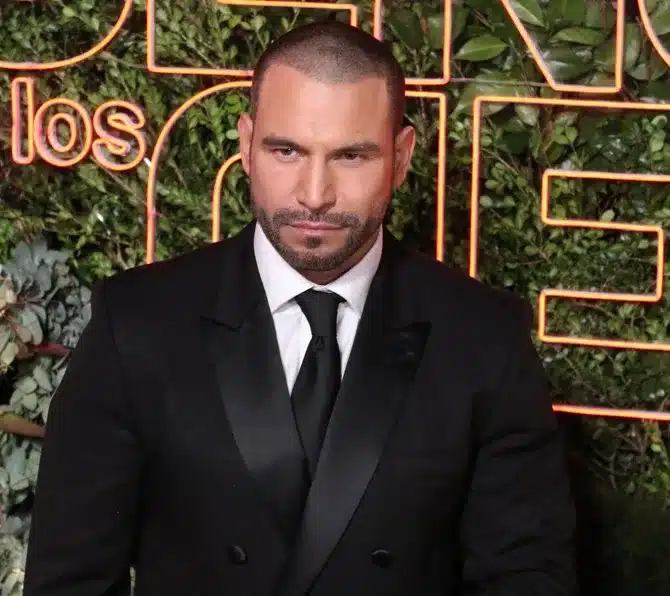

Rafael Amaya podría protagonizar serie producida por Emma Coronel

El actor Rafael Amaya vuelve a las narcoseries de mano de la mismísima esposa de Joaquín «El Chapo» Guzmán, ya que no solo dará vida al capo de las drogas, también será productor de la nueva serie junto con la pareja del ahora narcotraficante preso.

Amaya protagonizará y será productor ejecutivo de una serie bilingüe, contada desde la perspectiva de la esposa de Guzmán, Emma Coronel Aispuro, y centrada en su vida junto a su esposo.

Como productores ejecutivos, además del histrión, también se incluye a Coronel y su socia productora, Maritza Ramos, todo esto por medio de las empresas Amaya Productions y Zero Gravity Management («El Contador 1 y 2», «Ozark»).

Aunque el anunció ya fue confirmado por el portal Deadline.com, lo que también mencionó es que aún buscan un guionista para la emisión.

Guzmán es exlíder del cártel de Sinaloa condenado en un tribunal federal estadounidense en 2019 por múltiples cargos de narcotráfico y asociación delictuosa. En tanto, su esposa, Emma Coronel, cumplió tres años de prisión tras declararse culpable de narcotráfico y lavado de dinero. Fue liberada en 2023.

La serie, aún sin título, se describe como un drama criminal ficticio que explorará temas de poder, lealtad y supervivencia a través del viaje personal de la exreina de belleza de Sinaloa.

Internacionales

Un “ciclón bomba” azota y paraliza el noreste de EE.UU.

Una potente tormenta invernal, que los meteorólogos denominan “ciclón bomba”, ha azotado y paralizado el noreste de Estados Unidos. Más de 40 millones de personas están bajo advertencia de tormenta de nieve en la mañana de este lunes.

Asimismo, más de 260.000 usuarios de la región del Atlántico medio permanecen sin suministro eléctrico, principalmente en los estados de Nueva Jersey y Delaware. El alcalde de la ciudad de Nueva York, Zohran Mamdani, declaró el estado de emergencia el domingo y dispuso una prohibición de circulación de vehículos en toda la ciudad desde las nueve de la noche del domingo hasta el mediodía del lunes.

Muchos distritos escolares, incluidos los de las ciudades de Nueva York y Boston, declararon el lunes un “día de nieve” y suspendieron las clases presenciales, sin ofrecer enseñanza virtual. Miles de vuelos han sido cancelados en todo el país y los aeropuertos del área de Nueva York son los que han experimentado la mayor cantidad de interrupciones. Desde hace tiempo, expertos científicos vienen alertando de que el agravamiento de la crisis climática está provocando tormentas invernales cada vez más intensas.

La investigadora de la Universidad de Pensilvania Anabelle Horton afirmó que los datos muestran “que estas tormentas del nordeste, sumamente intensas y devastadoras, se volverán cada vez más destructivas y potentes en un clima cambiante”.