Tecnología

Google trabaja en un sistema para detectar el lenguaje de señas en las videollamadas

Google trabaja en tecnologías para hacer más accesibles las videollamadas y con este objetivo desarrolló un nuevo sistema que permite detectar en tiempo real cuándo un participante utiliza la lengua de signos, con el objetivo de destacarlos en las videollamadas grupales.

La mayor parte de los servicios de videollamadas utilizan sistemas para destacar a las personas que hablan en voz alta en las reuniones grupales, algo que supone inconvenientes para las personas con problemas de audición cuando se comunican mediante lengua de signos.

Para solucionar este problema, un equipo de investigadores de Google Research ha desarrollado un modelo de detección de la lengua de signos en tiempo real basado en la estimación de las poses que puede identificar a las personas como hablantes mientras se comunican con esta lengua.

El sistema desarrollado por Google, presentado en la conferencias europea de visión computarizada ECCV’20, emplea un diseño ligero con el que reduce la cantidad de carga de CPU necesaria para ejecutarlo, para no afectar así a la calidad de las llamadas.

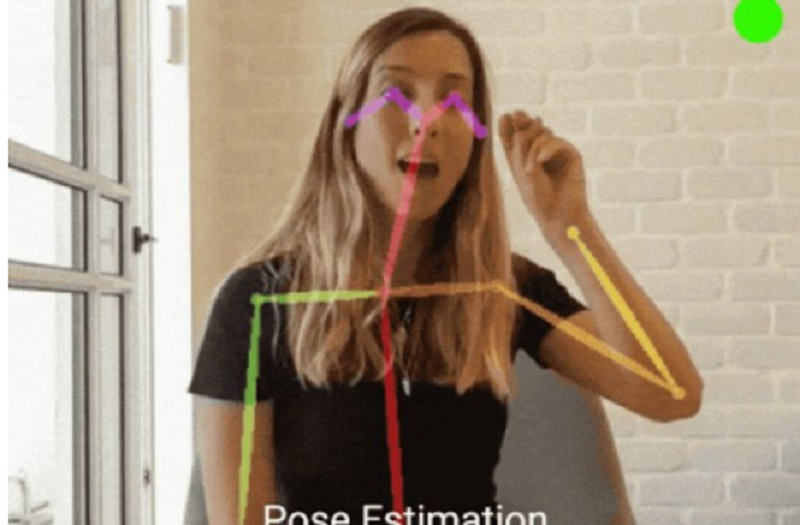

La herramienta utiliza un modelo de estimación de poses de brazos y manos, conocido como PoseNet, que reduce los datos de la imagen a una serie de marcadores en los ojos, nariz, manos y hombros del usuarios, entre otros, de manera que se detecta también el movimiento.

El modelo de Google presenta cerca del 80 por ciento de efectividad detectando a las personas que hablan lengua de signos cuando emplea tan solo 0,000003 segundos de datos, mientras que si se usan los 50 fotogramas anteriores la efectividad asciende hasta el 83,4 por ciento. Lenguaje de señas Google

Lenguaje de señas Google

Asimismo, los investigadores añadieron una capa adicional al modelo, de arquitectura de memoria a largo y corto plazo, que incluye “memoria sobre los pasos de tiempo anteriores, pero sin retroceso”, y con la que logra una efectividad del 91,5 por ciento en apenas 3,5 milisegundos.

Para mejorar la accesibilidad de las plataformas de videoconferencias, los investigadores han hecho su herramienta compatible con ellas, para que pueda usarse para señalar como ‘hablantes’ a quienes utilicen lengua de signos.

Este sistema emite ondas de sonido ultrasónicas cuando advierte a una persona que emplea esta lengua, de forma que las personas no las pueden percibir pero sí sus tecnologías de detección del habla, que destacan así al usuario en las videollamadas.

“Para comprender mejor qué tan bien funciona la demostración en la práctica, realizamos un estudio de experiencia del usuario en el que se pidió a los participantes que usaran nuestra demostración experimental durante una videoconferencia y que se comunicaran a través del lenguaje de señas como de costumbre. También se les pidió que se firmaran entre sí y sobre los participantes que hablaban para probar el comportamiento de cambio de altavoz. Los participantes respondieron de forma postiva cuando que el lenguaje de señas estaba siendo detectado y tratado como un habla audible, y que la demostración identificó exitosamente al asistente que firmaba y activó el ícono del medidor de audio del sistema de conferencias para llamar la atención sobre el asistente que firmaba”, se menciona en el comunicado difundido.

Los investigadores han publicado en código abierto en la plataforma GitHub su modelo de detección y esperan que su tecnología pueda “aprovecharse para permitir que los hablantes de lengua de signos utilicen las videoconferencias de manera más conveniente”.

Principal

La figura de Zuckerberg, centro del debate antes del juicio por adicción a las redes en EE.UU.

Un jurado en Estados Unidos comenzará a analizar el lunes una serie de alegatos para decidir si Instagram y YouTube diseñaron conscientemente sus plataformas para volver adictos a los niños, un caso inédito en el que la figura de Mark Zukerberg genera divisiones.

El caso, que se llevará en el Tribunal Civil Superior de Los Ángeles, podría establecer un precedente jurídico para una gran cantidad de litigios en Estados Unidos contra las plataformas, acusadas de haber causado deliberadamente la adicción para maximizar sus ingresos publicitarios.

La selección de los 12 jurados, avalados el viernes después de más de una semana de meticuloso escrutinio, estuvo marcada por las constantes referencias a Zuckerberg, el fundador de la compañía Meta propietaria de Instagram y Facebook.

Los abogados de Meta lucharon durante seis jornadas en el tribunal para apartar a los jurados que consideraban excesivamente hostiles a esas dos redes sociales.

Por otro lado, los abogados de la parte demandante buscaron excluir personas, en su mayoría hombres, que consideraban que los problemas de salud mental de los usuarios más jóvenes se deben más a fallos de las familias que a los diseñadores de las plataformas.

Los demandados en el juicio son Alphabet y Meta, los gigantes tecnológicos detrás de YouTube e Instagram, respectivamente.

Aunque TikTok y Snapchat también fueron acusados, ambas plataformas llegaron en días pasados a acuerdos por un monto no revelado.

El juicio se centra en las acusaciones de una mujer de 20 años identificada como Kelly G.M., quien sufrió graves daños mentales porque se volvió adicta a las redes sociales cuando era niña.

La joven, usuaria de YouTube desde los seis años y que abrió su cuenta de Instagram con 11, acusa a las dos plataformas de diseñar conscientemente aplicaciones adictivas, en perjuicio de su salud mental.

– Zuckerberg y el juicio –

La selección de los jurados, entre más de 150 ciudadanos, estuvo dominada por las evocaciones recurrentes del jefe de Meta.

«Me siento imparcial respecto a la demandante, pero, basándome en cosas que Mark Zuckerberg ha hecho objetivamente (…) creo que el demandado empezaría en desventaja», dijo una joven.

Muchos posibles jurados criticaron los inicios de Facebook, la cual fue diseñada como una plataforma para que estudiantes universitarios calificaran el atractivo de las mujeres, y citaron el caso de violación de privacidad de Cambridge Analytica en 2018.

También dijeron que les sería difícil aceptar el testimonio del multimillonario, el cual está previsto para las próximas dos semanas, sin prejuicios.

La abogada de Meta, Phyllis Jones, presentó objeciones frecuentes contra esos jurados. Dijo que era «muy importante que ambas partes empiecen con justicia, sin desventajas, que ustedes miren las pruebas con objetividad y decidan».

Otros fueron recusados por los abogados de la demandante por el motivo contrario. «Me cae bien este tipo», dijo un admirador de Zuckerberg. «Lamento no tener acciones de Meta».

– «Empresas muy diferentes»-

Los abogados de Alphabet se empeñaron en garantizar que su plataforma YouTube no se metiera en el mismo saco que Meta.

«¿Todos entienden que YouTube y Meta son empresas muy diferentes? ¿Todos entienden que (Zuckerberg) no dirige YouTube?», preguntó Luis Li, abogado de la plataforma de videos de Google.

Un hombre dijo que veía el potencial de YouTube para intentar provocar «descargas inmediatas de dopamina» entre los usuarios a través de su función ‘Shorts’.

Comentó que su sobrina pasa demasiado tiempo en TikTok, la plataforma que popularizó el desplazamiento infinito de videos en formato ultracorto.

El caso se centrará no en el contenido —ámbito en el que las plataformas están en gran medida protegidas por la legislación estadounidense—, sino en el diseño de algoritmos y funciones de personalización.

Meta y YouTube niegan rotundamente las acusaciones, y también argumentaron sin éxito el viernes para que el juez declarara ilegítimas las afirmaciones que comparan sus plataformas con el tabaco y otros productos adictivos.

Principal

Facebook cumple 22 años como una de las mayores plataformas sociales del mundo

Facebook cumplió 22 años este 4 de febrero de 2026, tras haber sido fundada en 2004 por Mark Zuckerberg y otros estudiantes de la Universidad de Harvard como una red para conectar a alumnos del campus. Posteriormente, la plataforma se expandió a otras universidades, luego a Estados Unidos y finalmente al resto del mundo.

Actualmente, Facebook forma parte de Meta Platforms, compañía que también controla servicios como Instagram y WhatsApp, adquiridos en 2012 y 2014 respectivamente. Con el paso de los años, la empresa evolucionó de ser una red social a un ecosistema tecnológico enfocado en comunicación digital, publicidad y desarrollo de nuevas tecnologías.

En términos de alcance, Facebook sigue siendo una de las plataformas más grandes del mundo. Datos recientes sitúan a la red social con alrededor de 3,000 millones de usuarios activos mensuales, consolidando su posición como uno de los servicios digitales más utilizados globalmente.

Pese a su crecimiento, la compañía ha enfrentado desafíos relacionados con privacidad, desinformación y regulación tecnológica, mientras continúa invirtiendo en inteligencia artificial y experiencias digitales como realidad virtual dentro de su estrategia futura.

Tecnología

Acer lanza su nueva línea de laptops Swift AI

Acer presentó su nuevo portafolio de laptops Swift AI, una generación de Copilot+ PCs con Windows 11 pensadas para creadores de contenido, profesionales en movimiento y usuarios que buscan alto rendimiento con funciones de inteligencia artificial integradas.

La familia está integrada por la Swift 16 AI, la ultraligera Swift Edge AI y la versátil Swift Go AI, disponible en versiones de 14 y 16 pulgadas.

La Acer Swift 16 AI es el modelo insignia de la marca. Está fabricada en aluminio y equipada con hasta un procesador Intel Core Ultra X9 388H y gráficos Intel Arc B390, lo que la orienta a tareas exigentes como edición y manejo de archivos pesados.

Es capaz de interactuar con herramientas creativas de IA mediante bocetos, animación, modelado y edición directamente en el touchpad. Además, incorpora una pantalla táctil OLED 3K de 16 pulgadas, con 120 Hz y cobertura del 100 % del espacio de color DCI-P3.

Por su parte, las Swift Edge 14 AI y Swift Edge 16 AI apuestan por la portabilidad. Con un peso inferior a 1 kg en el modelo de 14 pulgadas y un diseño ultradelgado, estas laptops combinan ligereza con resistencia de grado militar MIL-STD 810H.

Ambas están impulsadas por hasta un Intel Core Ultra 9 386H, con hasta 32 GB de memoria y 1 TB de almacenamiento, pensadas para profesionales que necesitan movilidad sin sacrificar rendimiento ni batería.

Mientras que las Swift Go 14 AI y la Swift Go 16 AI ofrecen un equilibrio entre desempeño, diseño y valor. Cuentan con chasis de aluminio, apertura de 180 grados y pantallas OLED táctiles en resoluciones 2K y 3K.

Integran procesadores Intel Core Ultra Serie 3 y funciones de Copilot+, como Click to Do, orientadas a mejorar la productividad mediante acciones rápidas basadas en el contenido en pantalla.